2025年1月,复旦大学工研院智能机器人研究院在国际顶级期刊 IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI) 上发表最新研究成果。复旦大学信息学院 2023届本科毕业生张靖东为第一作者,范佳媛青年副研究员为通讯作者,发表题为《BridgeNet: Comprehensive and Effective Feature Interactions via Bridge Feature for Multi-task Dense Predictions》的学术论文。

论文简介:

近年来,多任务学习(Multi-task Learning, MTL)在处理多个密集预测任务(如语义分割、深度估计等)时展现了强大的潜力。然而,现有方法在任务间特征交互时存在以下瓶颈:

特征表征不完整:仅使用低级或高级特征,无法充分捕获任务间的潜在关系。

语义区分性较差:任务特异性特征质量低,影响后续交互效果。

交互效率低下:任务间交互复杂度通常随任务数量呈平方增长,扩展性受限。

为解决上述问题,研究团队提出了创新性框架 BridgeNet,其核心思想是通过桥接特征(Bridge Features)实现全面有效的任务交互,同时显著降低交互复杂度。

该框架核心模块:

Task Pattern Propagation (TPP):消除任务模式的混淆,生成高质量的任务特异性特征。

Bridge Feature Extractor (BFE):通过 Transformer 模块整合任务通用特征与任务特异性特征,生成包含多层次表征的桥接特征。

Task Feature Refiner (TFR):利用桥接特征逐步优化任务特异性特征,实现高效、线性复杂度的任务交互。

框架优势:

全面的特征交互:结合低级和高级特征,提升任务间信息共享的完整性。

高效的任务交互:线性复杂度设计,适合大规模任务扩展。

优异的任务性能:在 NYUD-v2、Cityscapes 和 PASCAL Context 等基准数据集上,BridgeNet 在多个密集预测任务上均超越现有最先进方法(如 InvPT 和 MTI-Net)。

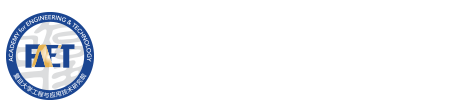

图1. BridgeNet框架图

如图1所示,我们的方法以深度估计和语义分割为例,通过共享图像骨干网络(shared image backbone)对任务通用特征(task-generic features)进行编码,并通过带有深度监督的初始解码器(preliminary decoders)提取任务特异性特征(task-specific features)。为了解决任务模式混淆问题(task-pattern-entanglement issue),我们在初始预测生成之前提出了Task Pattern Propagation(TPP)模块。生成的高质量任务特异性特征并不会直接用于交互,而是先经过Bridge Feature Extractor(BFE)在各尺度上处理,融入低级特征并生成桥接特征(bridge features)。随后,这些多尺度的桥接特征用于逐步优化任务特异性特征,通过Task Feature Refiner(TFR)进一步精炼。最终,经过TFR优化的特征会被聚合并输入到任务特异性预测头中以生成最终预测结果。

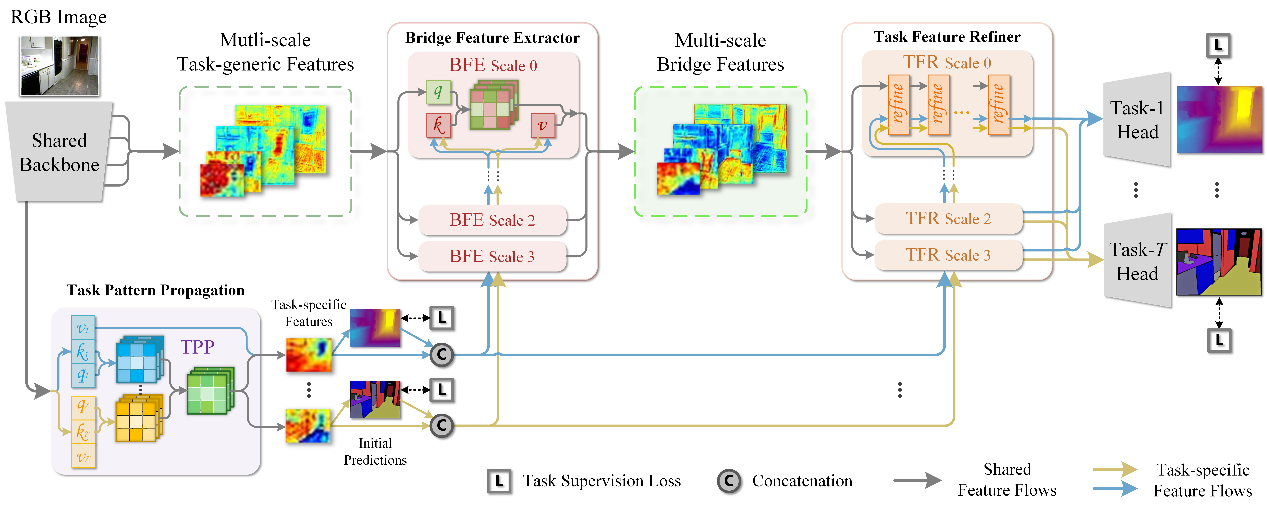

图2. MTI-Net (a)与BridgeNet (b)的特征可视化对比。

如图2所示,我们的方法对同一语义区域呈现出更高的一致性和清晰的边缘。区域越亮,意味着对这些区域的关注度越高。在深度估计(右)中,我们的方法还为不同深度的区域生成了更准确的边缘,例如远处的门应该是最亮的区域。T1 和 T2 分别表示语义分割和深度估计标签。

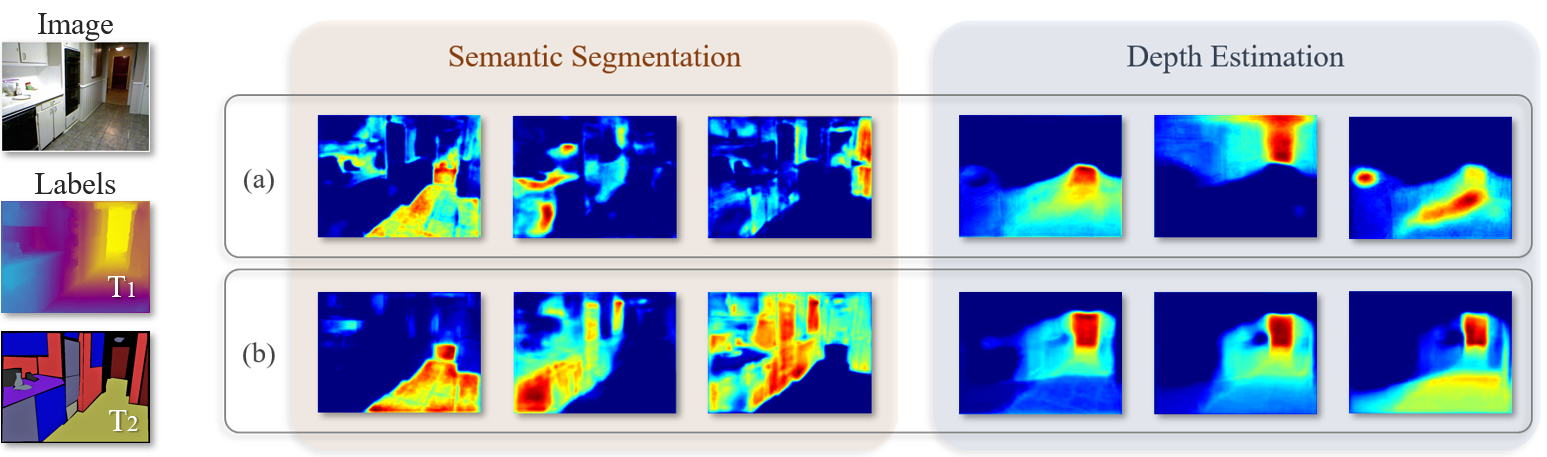

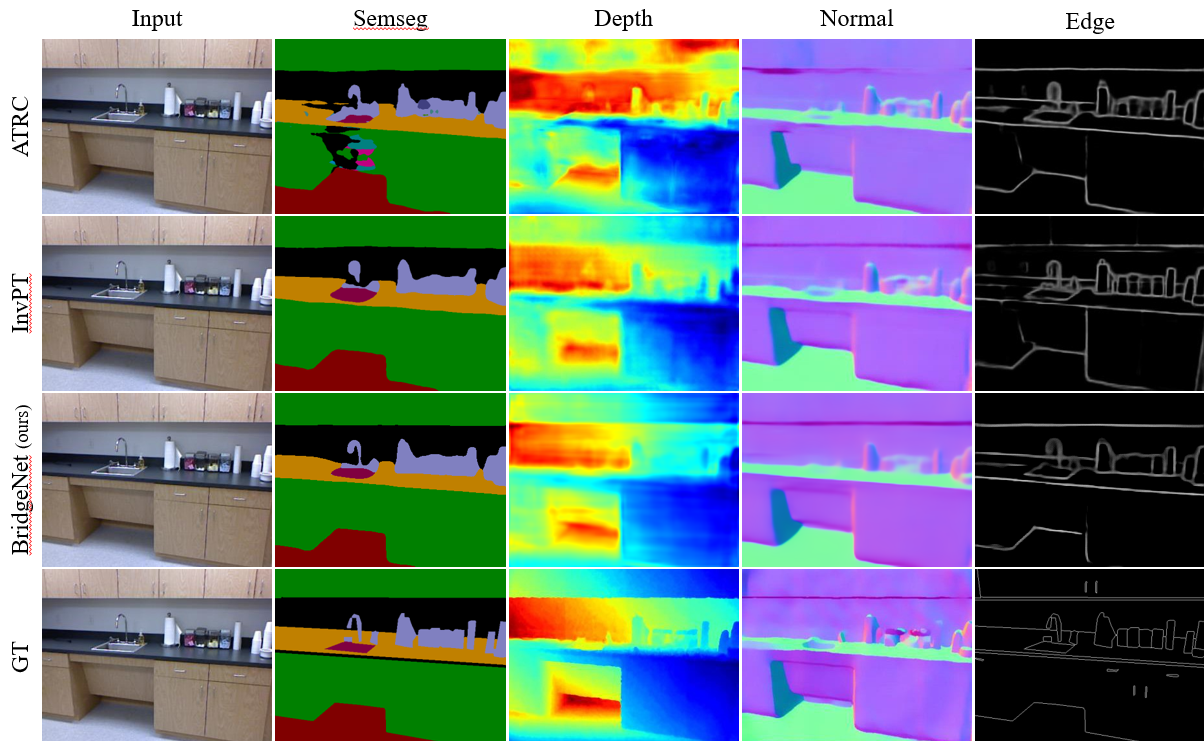

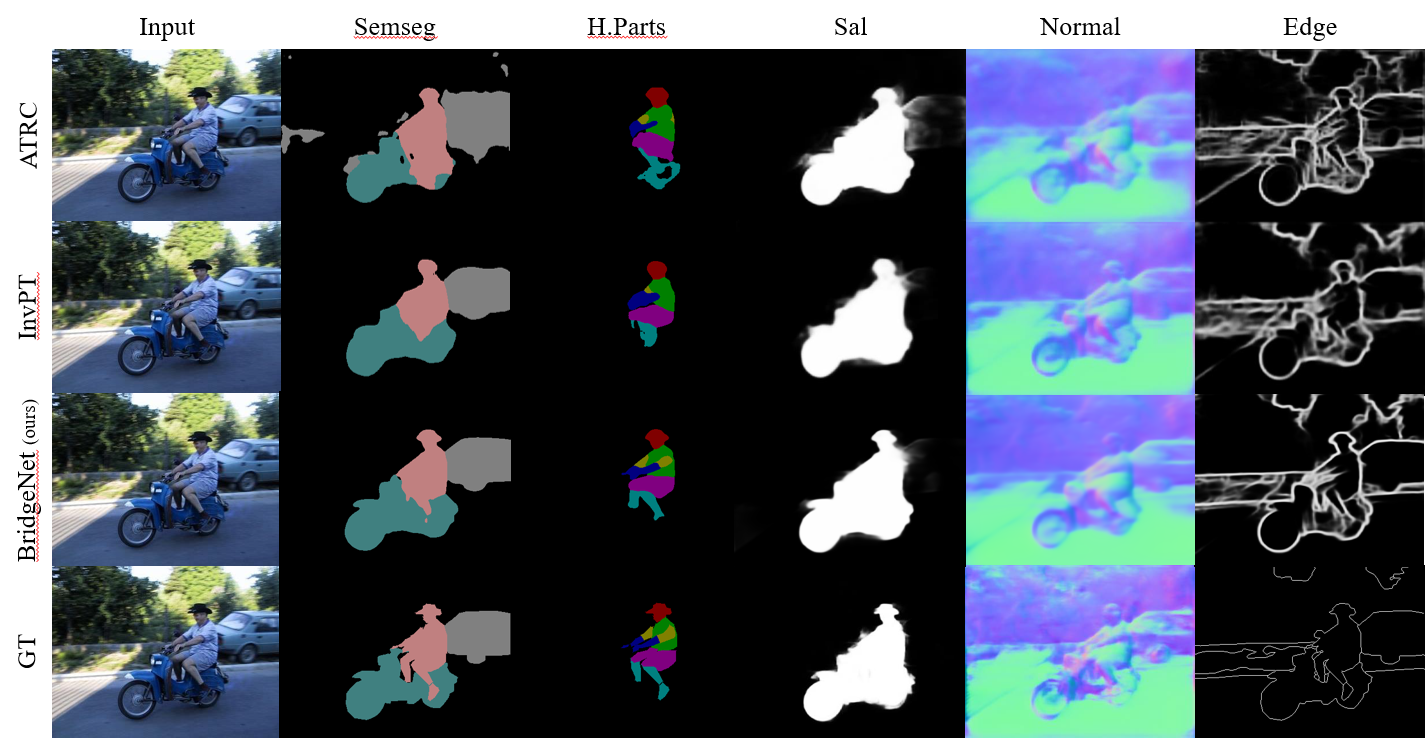

如图3和图4所示,在多任务场景理解的数据集上进行了大量实验,结果表明BridgeNet表现优异。具体而言,在语义分割、深度估计、表面法线估计和边缘检测等任务上,BridgeNet 显著提升了预测精度。例如,在 NYUD-v2 数据集上,语义分割任务的 mIoU 比 InvPT 提升 3.01%,深度估计的 rmse 降低 0.0528。在 PASCAL Context 数据集上,由于任务数量增加,在多个任务之间实现性能平衡变得具有挑战性。尽管如此,即使在这些条件下,我们也在所有任务中实现了均衡的提升。在人体部位分割 (H.Parts) 和显著性估计 (Sal.) 方面取得了更显著的改进。

图3. BridgeNet在室内场景数据集NYUDv2上可视化效果与其他SOTA对比。

图4. BridgeNet在PASCAL-Context上可视化效果与其他SOTA对比。

原文链接:https://arxiv.org/abs/2312.13514

延伸阅读:

《IEEE Transactions on Pattern Analysis and Machine Intelligence》(TPAMI)由IEEE出版,是计算机视觉与模式识别领域的国际顶级期刊,致力于发表图像处理、机器学习、计算机视觉等领域的前沿研究成果,为SCI一区Top期刊,并被中国科协列为高质量科技T1类期刊。TPAMI长期以来在国际学术界享有极高声誉,是模式识别与人工智能领域学者的重要交流平台,其发表的文章涵盖了深度学习、目标检测、语义分割、强化学习等多个热门研究方向。

范佳媛是复旦大学工研院智能机器人研究院和智能机器人教育部工程研究中心的主要研究成员之一,复旦大学工研院副院长、智能机器人研究院院长甘中学教授为MAGIC Lab首席PI。本实验室主要依托上海市人工智能市级重大专项,面向国家《新一代人工智能发展规划》中的群体智能理论、自主协同控制与优化决策理论、群体智能关键技术等重要科学方向,融合非线性动力学、模式识别、计算神经科学、强化学习、集群智能等多领域的理论与方法,重点探究人机物协同与智能融合的科学原理,突破异构群体行为协作与动态演变的关键技术,构建智慧交通与智能制造等场景下的异构集群交互系统。